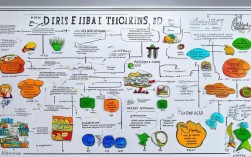

自然语言处理(NLP)作为人工智能领域的重要分支,致力于让计算机理解、解释和生成人类语言,其技术体系复杂且应用广泛,构建NLP思维导图需从核心目标出发,梳理关键技术模块、应用场景及发展趋势,形成系统化的知识框架,以下从技术层级、核心任务、关键模型、应用领域及挑战五个维度展开详细分析。

技术层级:从底层到应用的全栈体系

NLP技术栈可分为数据层、基础层、模型层和应用层,数据层包括文本语料库(如维基百科、新闻语料)和预标注数据集(如GLUE、SuperGLUE),需经过清洗、分词、去重等预处理;基础层涵盖词嵌入(Word2Vec、GloVe)、词性标注(POS Tagging)、命名实体识别(NER)等基础任务,为上层模型提供结构化语言特征;模型层以深度学习为核心,从RNN、LSTM到Transformer架构,再到预训练语言模型(BERT、GPT系列),不断突破语义理解边界;应用层则直接面向用户需求,包括机器翻译、情感分析、智能问答等场景化系统。

核心任务:理解与生成的双向突破

NLP核心任务可分为理解类与生成类两大方向,理解类任务聚焦文本语义解析,如文本分类(新闻分类、情感极性判断)、关系抽取(实体间语义关联识别)、语义角色标注(句子成分功能划分)及问答系统(阅读理解与答案生成);生成类任务侧重自然语言输出,包括机器翻译(多语言转换)、文本摘要(长文本压缩)、对话系统(多轮交互)及创意写作(诗歌、故事生成),近年来,以Prompt Engineering为代表的提示学习技术成为连接预训练模型与下游任务的桥梁,显著提升了模型对复杂指令的适应能力。

关键模型:从统计学习到预训练范式

NLP模型发展历经三次范式革新,早期基于统计的方法(如HMM、CRF)依赖人工特征工程,适合规则明确的简单任务;2013年后,词嵌入技术(Word2Vec)将词语映射为低维向量,捕捉语义相似性,结合RNN/LSTM解决序列依赖问题;2017年Transformer模型提出自注意力机制,并行计算能力大幅提升效率,催生了BERT(双向编码器)和GPT(自回归解码器)两大预训练范式,当前,大语言模型(LLM)如GPT-4、LLaMA通过海量数据训练,展现出零样本学习、思维链推理等涌现能力,但同时也面临训练成本高、数据偏见等问题。

应用场景:多行业渗透的智能变革

NLP技术已在多个领域实现深度应用,在金融行业,智能客服(如银行FAQ机器人)降低人工成本,舆情分析系统实时监测市场情绪;医疗领域,电子病历自动解析提升诊疗效率,医学文献挖掘辅助新药研发;教育行业,作文智能批改系统实现个性化反馈,语言学习APP提供实时口语评测;司法领域,合同审查工具自动识别风险条款,案例推荐系统辅助法官量刑,NLP与多模态技术融合(如图文生成DALL-E 3)进一步拓展了应用边界,推动AIGC(人工智能生成内容)产业爆发式增长。

挑战与趋势:伦理与技术的双重演进

尽管NLP发展迅速,仍面临诸多挑战,技术层面,模型可解释性差(如“黑箱”问题)、小样本学习效率低、多语言资源不均衡(低资源语言效果差)亟待突破;伦理层面,数据偏见(如性别、种族歧视)、深度伪造(Deepfake文本)、隐私泄露风险需加强监管;安全层面,对抗样本攻击(如输入微小扰动导致误判)威胁系统鲁棒性,未来趋势包括:模型轻量化(如DistilBERT降低部署成本)、领域自适应(预训练模型+微调适配特定场景)、多模态融合(文本与图像、语音跨模态理解)及联邦学习(数据不出库的协同训练)。

相关问答FAQs

Q1:预训练语言模型(如BERT)与传统NLP模型的核心区别是什么?

A1:传统模型(如SVM、HMM)依赖人工特征工程,需针对每个任务设计特定特征;而BERT等预训练模型通过无监督学习从海量文本中捕获通用语言知识,通过微调(Fine-tuning)即可适配下游任务,显著减少人工干预,同时提升复杂语义理解能力,BERT的双向编码机制能同时考虑上下文信息,解决了RNN单向依赖的局限。

Q2:如何解决NLP模型中的数据偏见问题?

A2:解决数据偏见需从数据、算法、评估三方面入手:数据层面,采用去偏见数据增强(如回译技术生成多样化样本)、平衡数据分布(确保不同群体样本比例合理);算法层面,引入对抗学习(如Adversarial Debiasing)训练偏见感知模型,或设计公平性约束损失函数;评估层面,建立偏见检测指标(如StereoSet测试集),定期审计模型输出结果,确保决策公平性。